1. Introdução

A previsão de inflação é uma das tarefas mais complexas na macroeconomia moderna, dada a presença de não-linearidades e a interdependência dinâmica entre diversas variáveis econômicas. Enquanto modelos econométricos tradicionais (como ARIMA ou VAR) oferecem uma base robusta, o avanço da Inteligência Artificial permite capturar padrões mais sofisticados.

Neste exercício, exploramos a previsão de séries temporais utilizando o Temporal Fusion Transformer (TFT). O TFT é uma arquitetura de Deep Learning baseada em mecanismos de atenção, desenhada especificamente para lidar com múltiplas variáveis e horizontes de previsão longos, mantendo a interpretabilidade — uma característica frequentemente ausente em modelos de "caixa-preta".

2. Objetivo

O objetivo principal deste estudo é construir um modelo preditivo para a inflação brasileira (IPCA acumulado em 12 meses) com um horizonte de previsão de 12 meses à frente.

Para isso, buscamos:

-

Implementar uma Curva de Phillips Aumentada dentro de uma arquitetura de rede neural.

-

Utilizar a biblioteca darts para facilitar o pipeline de Machine Learning (pré-processamento, treino e validação).

-

Gerar previsões probabilísticas (com intervalos de confiança) em vez de apenas estimativas pontuais.

3. Dados

Os dados foram coletados diretamente do Banco Central do Brasil (SGS e Focus) via biblioteca python-bcb, compreendendo o período de 1999 a 2025. A variável alvo (target) é o IPCA acumulado em 12 meses.

Para explicar a inflação, utilizamos as seguintes covariáveis (baseadas na teoria econômica):

-

Inércia Inflacionária: Defasagens da própria inflação.

-

Expectativas de Inflação: Mediana do relatório Focus (suavizada para 12 meses).

-

Hiato do Produto: Calculado a partir do IBC-Br. Aplicou-se o Filtro Hodrick-Prescott (HP) para extrair a tendência e isolar o ciclo econômico (hiato), medindo a ociosidade ou superaquecimento da economia.

-

Inflação Importada: Variação do Índice de Commodities Brasil (IC-Br) em reais, capturando choques de oferta e câmbio.

4. Metodologia

4.1. Framework e Modelo

Utilizou-se a biblioteca darts, que unifica a interface para modelos de séries temporais em Python. O modelo escolhido foi o TFTModel (Temporal Fusion Transformer).

4.2. Configuração do Modelo

O TFT foi configurado para aprender relações temporais complexas com os seguintes hiperparâmetros:

-

Input Chunk Length (24): O modelo "olha" para os últimos 24 meses de dados para tomar uma decisão.

-

Output Chunk Length (12): O modelo é treinado para prever 12 meses à frente de uma só vez.

-

Hidden Size (128) e Attention Heads (4): Aumentam a capacidade do modelo de processar informações e focar em momentos específicos do passado que são relevantes para o futuro.

-

Quantile Regression: A função de perda foi configurada para regressão quantílica. Isso permite que o modelo gere não apenas uma linha de previsão, mas uma distribuição de probabilidade (intervalos de confiança de 1% a 99%), essencial para análise de risco.

4.3. Pré-processamento

Os dados foram divididos em treino e validação. Foi aplicado um Scaler para normalizar todas as variáveis entre 0 e 1, procedimento padrão para garantir a convergência eficiente de redes neurais.

5. Análise dos Resultados

5.1. Treinamento do TFT

O modelo foi treinado por 300 épocas. Observou-se uma redução consistente na perda de treinamento (train_loss), indicando que a rede neural conseguiu aprender os padrões históricos dos dados.

5.2. Previsão e Incerteza (Gráfico de Projeção)

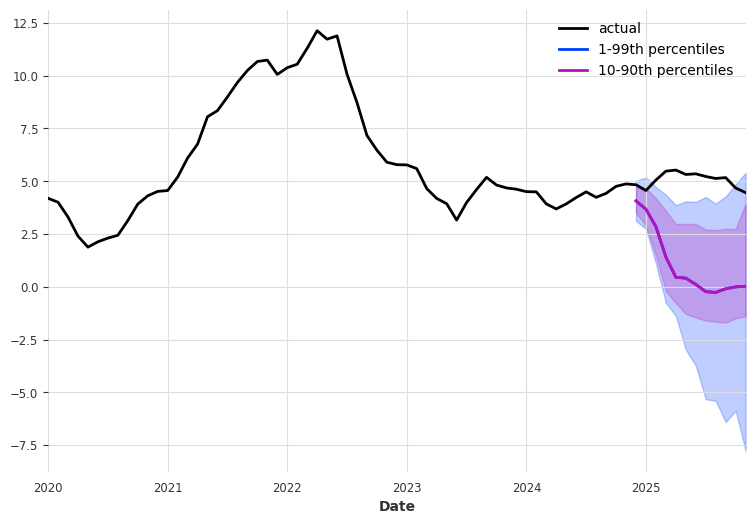

O gráfico apresenta a projeção do IPCA para o horizonte de 2025.

Trajetória: O modelo TFT projetou uma desaceleração acentuada da inflação (linha roxa central), divergindo para baixo em relação ao patamar observado no final da amostra histórica. Isso sugere que o modelo está reagindo fortemente a alguma covariável (possivelmente uma abertura no hiato do produto ou queda nas commodities/expectativas no final da série).

Intervalos de Confiança (Fan Chart): As áreas sombreadas em azul e roxo representam os quantis. Nota-se que o "cone" de incerteza se abre conforme o horizonte de previsão se distancia, o que é esperado. A amplitude dos intervalos indica que, embora a tendência central seja de queda, existe uma probabilidade estatística relevante de a inflação permanecer em patamares mais altos (borda superior da área sombreada).

5.3. Interpretabilidade

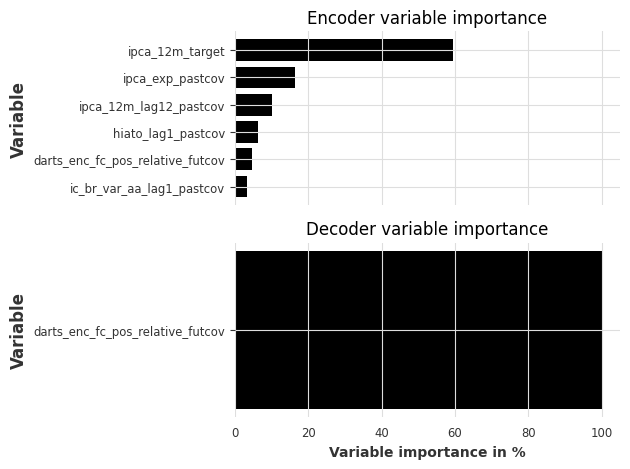

A análise da interpretabilidade fornecida pelo Temporal Fusion Transformer revela, através dos pesos atribuídos pelo mecanismo de atenção no Encoder, que a dinâmica inflacionária brasileira capturada pelo modelo é predominantemente inercial. A variável de maior peso explicativo é a própria trajetória histórica do IPCA acumulado, que responde por cerca de 60% da importância na construção do contexto pelo modelo. Esse resultado corrobora a literatura econométrica tradicional e a realidade dos mecanismos de indexação da economia brasileira, onde a inflação passada é o principal determinante da inflação futura.

Em um segundo patamar de relevância, destacam-se as Expectativas de Inflação provenientes do relatório Focus, validando a tese de que o canal das expectativas e a credibilidade da política monetária desempenham um papel crucial na formação de preços, superando inclusive o peso de variáveis estruturais clássicas da Curva de Phillips, como o Hiato do Produto e a inflação importada via Commodities (IC-Br), que aparecem com contribuições marginais neste modelo específico. Por fim, a predominância absoluta da codificação posicional relativa no Decoder reflete uma característica técnica da configuração do modelo: como não foram inseridas variáveis exógenas conhecidas para o futuro (como feriados ou alterações tributárias programadas), a projeção baseia-se inteiramente na extrapolação temporal da dinâmica inercial e das correlações aprendidas no passado pelo Encoder.

6. Considerações Finais

Os resultados obtidos indicam que a configuração atual dos parâmetros do modelo TFT subestimou a inflação acumulada em 12 meses. Isso aponta para a necessidade de ajustes na especificação da rede ou nos hiperparâmetros para capturar melhor a dinâmica recente dos preços. Além disso, a validação restrita a um único corte temporal não é suficiente para atestar a generalização do modelo; testes de backtesting em múltiplos períodos são indispensáveis para uma avaliação definitiva.

Outro fator limitante é a intensidade computacional. O tempo significativo de treinamento torna o TFT menos aconselhável para estimativas rápidas (nowcasting) ou para ambientes sem processamento dedicado, devendo ser reservado para análises estruturais onde a precisão em horizontes longos justifique o custo de processamento.