Colab AI

O Colab AI é um novo recurso disponível1 no Google Colab que permite programar com o auxílio de inteligência artificial. O usuário pode digitar um simples prompt como “Gere um gráfico de série temporal”, preferencialmente em inglês, e a inteligência artificial gera um código para realizar a tarefa solicitada.

Para utilizar o recurso você deve estar logado na sua conta do Google e seguir estes passos:

- Acessar/criar um notebook do Google Colab em https://colab.new/

- Navegar por Tools > Settings > Colab AI

- Marcar a caixa “Consented to use generative AI features”

- Ler as políticas associados ao recurso e clicar em Next

- Ler os termos associados ao recurso, marcar a caixa de concordância e clicar em Finish

- Criar um célula de código clicando em “+ Code”

- Clicar em “generate” dentro da célula de código

- Digitar o prompt de instrução para o modelo gerar um código e pressionar Enter

O código gerado pela inteligência artificial será inserido automaticamente na célula de código. Basta executar para ver o resultado e fazer ajustes para melhorias ou para resolver erros!

Para obter o código e o tutorial deste exercício faça parte do Clube AM e receba toda semana os códigos em R/Python, vídeos, tutoriais e suporte completo para dúvidas.

GitHub Copilot

O Github Copilot é um recurso pago disponível para usuários da plataforma GitHub que permite progamar com a ajuda de um “assistente” fornecendo sugestões de código. O usuário pode digitar uma simples instrução na forma de um comentário e o recurso sugere o código que realiza a tarefa.

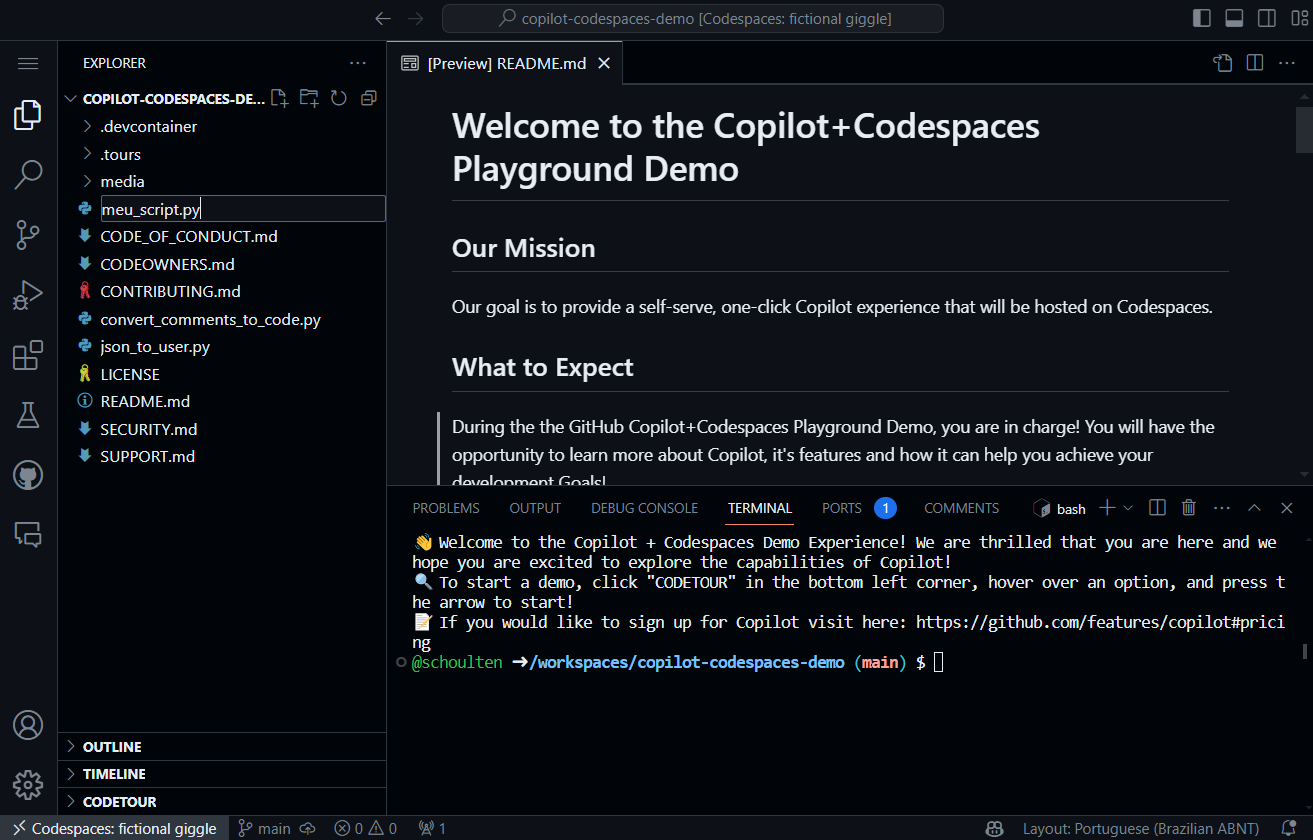

Para testar a utilização do recurso você deve estar logado na sua conta do GitHub e seguir estes passos:

- Acessar a página de teste do recurso em https://resources.github.com/copilot-demo/

- Clicar em Test in browser

- Clicar em Create new codespace e aguardar a tela do VS Code ser carregada

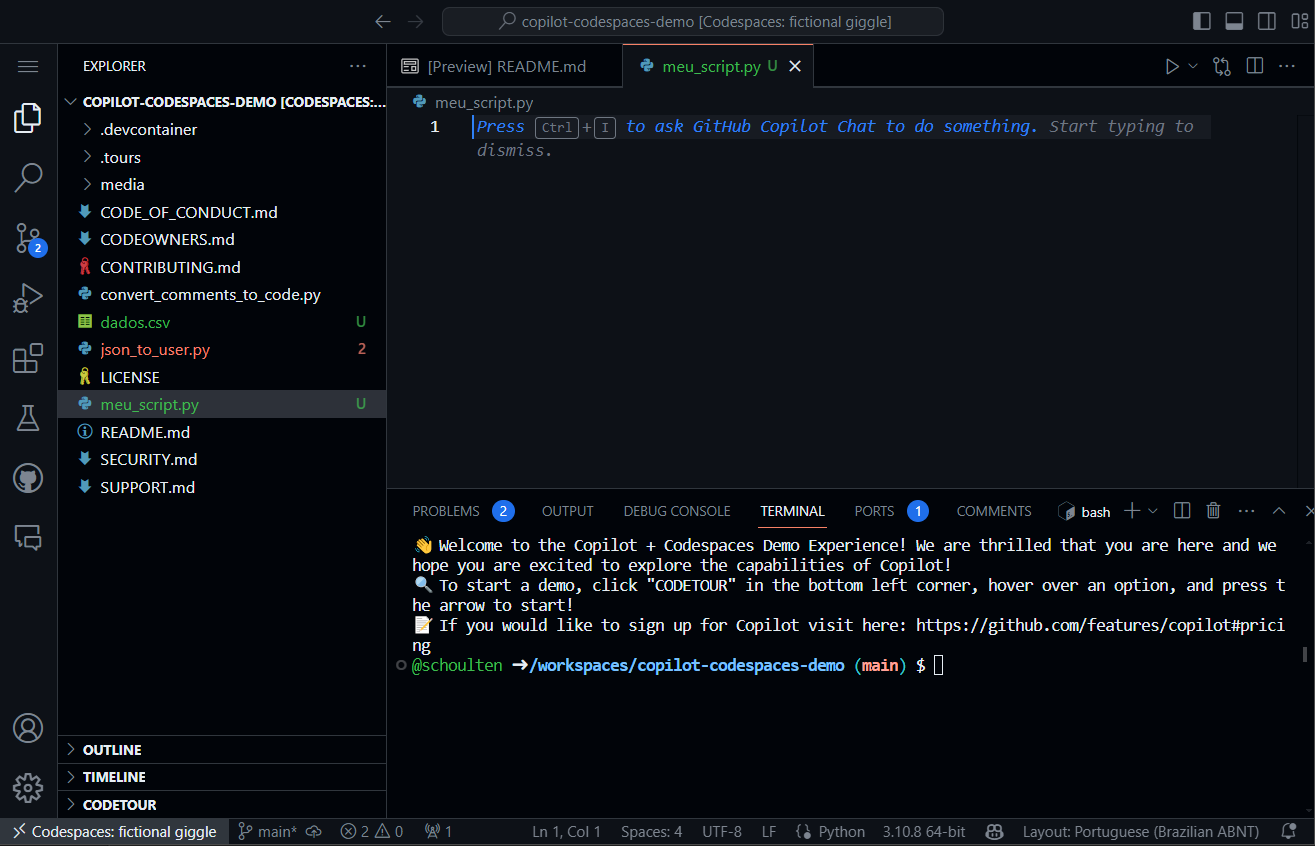

- Clicar em Explorer > New file, digite meu_script.py e pressioner Enter

- Abrir o arquivo meu_script.py recém criado

- Inserir um comentário com a instrução desejada para o Copilot gerar o código

Pressione Enter ao finalizar o comentário, aguarde a sugestão aparecer na tela e, caso concorde com a sugestão, pressioner Tab para completar com o código.

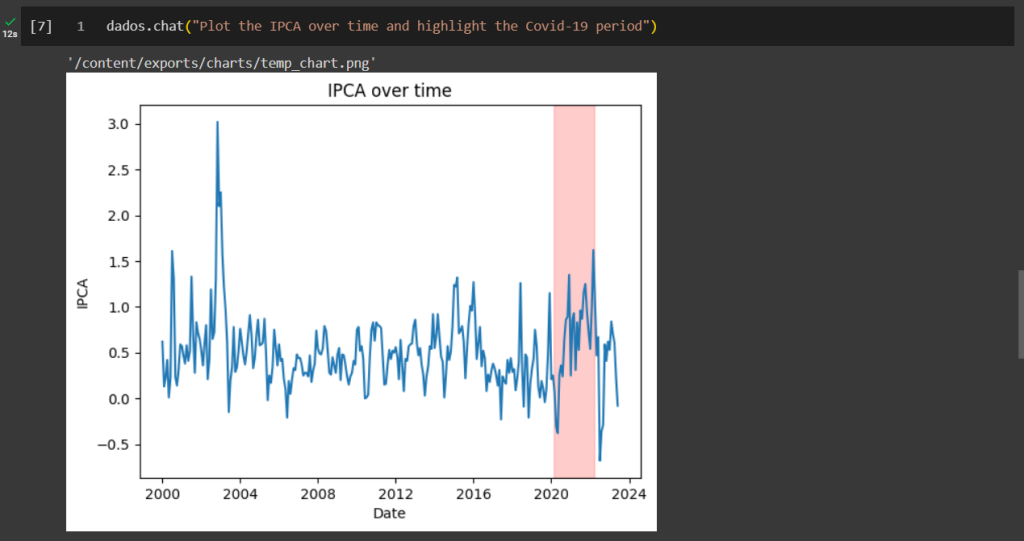

PandasAI

A biblioteca PandasAI foi lançada recentemente para possibilitar que usuários de Python possam rapidamente fazer análises de dados tabulares (DataFrames) utilizando inteligência artificial de modelos de linguagem grande (LLMs). O usuário pode utilizar vários modelos, como ChatGPT, Google PaLM, LangChain e outros, como fonte de análise dos dados, o que possibilita criar gráficos, extrair informação, prever valores, etc. sem precisar escrever código.

Para testar a utilização da biblioteca você deve seguir estes passos:

- Acesse seu ambiente de programação Python, como, por exemplo, o Colab https://colab.new/

- Instale a biblioteca usando as instruções da documentação https://docs.pandas-ai.com/en/latest/

- Importe o que for relevante da biblioteca (aqui exemplificares o uso com o modelo Google PaLM)

- Importe seus dados

- Verifique na documentação da biblioteca como obter a chave de API do modelo e, usando a mesma, faça a autenticação

- Escreva seu prompt de análise de dados (veja técnicas de Prompt Engineering para otimizar resultados)

Nota: a biblioteca está em fase inicial de desenvolvimento, problemas de instalação e outros podem acontecer. Para dúvidas, acesse a documentação, repositório e/ou código fonte.

Conclusão

Neste artigo mostramos 3 ferramentas que podem ajudar analistas a resolver tarefas do dia a dia de forma mais rápida, agregando inteligência artificial na análise de dados. Seja para completar código ou para análises de dados descritivas e preditivas avançadas, estas ferramentas são simples de usar e se integram com o Python.

Quer aprender mais?

Clique aqui para fazer seu cadastro no Boletim AM e baixar o código que produziu este exercício, além de receber novos exercícios com exemplos reais de análise de dados envolvendo as áreas de Data Science, Econometria, Machine Learning, Macroeconomia Aplicada, Finanças Quantitativas e Políticas Públicas diretamente em seu e-mail.

Notas de rodapé

- Atualmente disponível para contas que não sejam do Google Workspace.↩︎