Captar nuances de linguagem, características culturais e diferenças de dialetos pode ser difícil para modelos de IA generativa treinados com a maior parte dos textos em inglês. A depender do tipo de tarefa que o usuário solicite, estas particularidades podem impossibilitar uma solução adequada por parte da IA generativa.

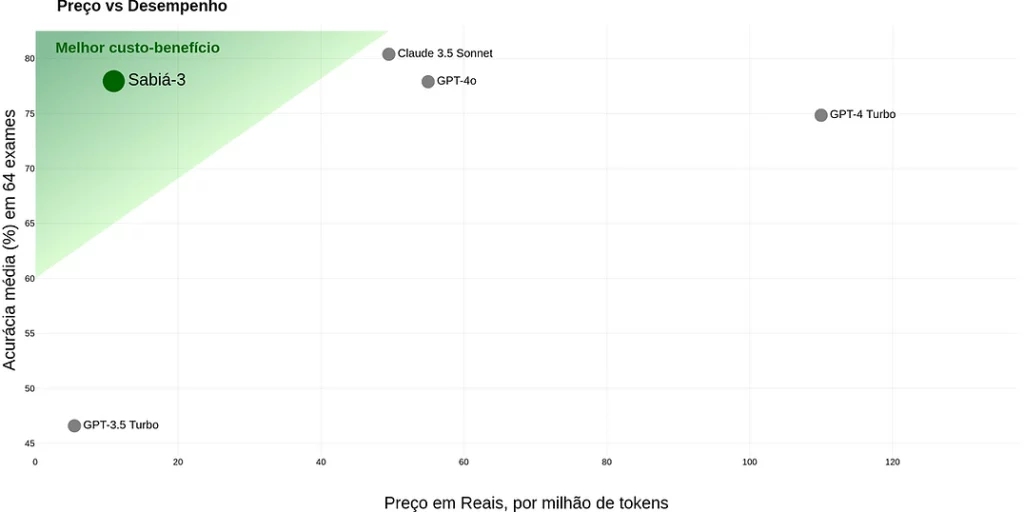

Neste exercício mostramos como utilizar um LLM brasileiro, o Sabiá-3, desenvolvido pela empresa Maritaca AI. De acordo com a empresa, o modelo possui um custo-benefício melhor do que outras opções famosas, como GPT-4o. Isso significa que o custo de inferência é menor ou equivalente para um mesmo nível acurácia do modelo.

A seguir mostramos como usar o Sabiá-3 pela linguagem de programação Python.

Passo 01: criar conta na Maritaca e obter chave de API

Para usar a IA brasileira fornecida pela Maritaca via Python, é necessário ter uma conta cadastrada e gerar um chave de API. Para fazer isso, siga os procedimentos abaixo:

- Acessar o link https://plataforma.maritaca.ai/

- Clicar em “Entrar”

- Digitar informações de login e/ou se cadastrar

- Clicar em “Chaves de API” no menu esquerdo

- Clicar em “Criar Nova Chave”

- Clicar em “Criar”

- Clicar em “Copiar” e armazenar em local protegido/seguro (importante: essa é uma informação sensível)

Passo 02: cadastrar forma de pagamento para uso da API

Atualmente, a Maritaca oferece modelos pagos de IA, mas disponibiliza gratuitamente créditos de utilização para testar os modelos via Python. Para obter os créditos, no entanto, é necessário cadastrar um cartão de crédito. Para fazer isso, siga os procedimentos abaixo:

- Ainda em https://plataforma.maritaca.ai/, clicar em “Recarga”

- Em “Cartões Cadastrados”, clicar em “Gerenciar”

- Clicar no botão de adicionar

- Digitar informações do seu cartão de crédito e clicar em “Save card”

Passo 03: enviar prompt via API usando Python

Por fim, podemos escrever um código simples de Python para se conectar à API da Maritaca para uso do modelo de IA generativa Sabiá-3. Para fazer isso, siga os procedimentos abaixo:

- Acessar o Google Colab pelo link https://colab.new/

- Clicar em Secrets na lateral esquerda do Colab

- Clicar no botão “Add new secret”

- Clicar no botão de habilitar embaixo de “Notebook access”

- Digitar “MARITALK_API_KEY” no campo “Name”

- Digitar a chave de API obtida acima no campo “Value”

- Instalar a biblioteca maritalk via comando

pip install maritalk - Importar as bibliotecas via comando

import maritalk from google.colab import userdata - Definir o modelo e se autenticar via comando

model = maritalk.MariTalk(key = userdata.get("MARITALK_API_KEY"), model = "sabia-3") - Enviar prompt e obter resposta via comando

response = model.generate("Explique o que é altinha em um parágrafo.") print(response["answer"])

A resposta obtida do modelo Sabiá-3 neste exemplo foi:

“A altinha é uma prática esportiva e recreativa que envolve manter uma bola de futebol no ar utilizando diversas partes do corpo, especialmente os pés, pernas, coxas, peito, cabeça e ombros, sem deixá-la cair. É uma atividade que exige habilidade, coordenação motora e resistência, muitas vezes realizada em grupo, onde os participantes passam a bola uns para os outros sem deixar a bola tocar o solo. Popular no Brasil e em outras partes do mundo, a altinha é uma expressão cultural que mistura esporte, arte e diversão, sendo também uma forma eficaz de treinamento para jogadores de futebol, pois melhora o controle de bola e a agilidade.”

Já a resposta obtida do modelo GPT-4o, da OpenAI, foi:

“Altinha é um jogo desportivo e recreativo originário do Brasil, popular especialmente nas praias. Trata-se de uma variação do futebol de areia, onde o objetivo principal é manter a bola no ar sem deixá-la tocar o chão, usando qualquer parte do corpo, exceto as mãos. Os jogadores formam um círculo ou uma linha e trocam passes curtos e rápidos, valorizando a habilidade e o controle de bola. A atmosfera competitiva, porém descontraída, atrai praticantes de todas as idades e promove tanto a prática de atividade física quanto a socialização em ambientes ao ar livre.”

Conclusão

Modelos de IA costumam ser treinados majoritariamente em inglês, mas para algumas tarefas os modelos em português podem ser mais adequados. Neste exercício mostramos como utilizar um LLM brasileiro, o Sabiá-3, que apresenta um custo-benefício melhor do que outras opções famosas.