Introdução

Você já pensou em automatizar a análise do mercado de trabalho brasileiro? Neste post, vamos mostrar como construir um sistema de agentes inteligentes com o framework LangGraph, integrando dados estruturados do IBGE/SIDRA e informações não estruturadas vindas de notícias em tempo real.

Objetivo

Nosso objetivo é construir um agente de análise do mercado de trabalho, capaz de responder perguntas com base em:

- Dados da tabela 6318 do SIDRA/IBGE;

- Notícias recentes relacionadas ao mercado de trabalho;

- Coordenação inteligente entre diferentes agentes especializados.

Para obter o código e o tutorial deste exercício faça parte do Clube AM e receba toda semana os códigos em R/Python, vídeos, tutoriais e suporte completo para dúvidas.

Framework: LangGraph

Construímos o pequeno sistema por meio do Framework LangGraph.

O LangGraph foi desenvolvido para lidar com fluxos de trabalho mais sofisticados e complexos.

Enquanto o LangChain se destaca na criação de cadeias simples de tarefas, o LangGraph vai além ao oferecer uma abordagem baseada em grafos de estado, ideal para orquestrar fluxos conversacionais mais ricos e pipelines de dados com múltiplas interações.

Isso torna o LangGraph especialmente útil em projetos que envolvem:

-

Múltiplos agentes especializados

-

Lógica condicional para tomada de decisões

-

Interações com estado persistente

Com o LangGraph, conseguimos construir sistemas conversacionais muito mais flexíveis, responsivos e alinhados ao comportamento esperado de um analista humano.

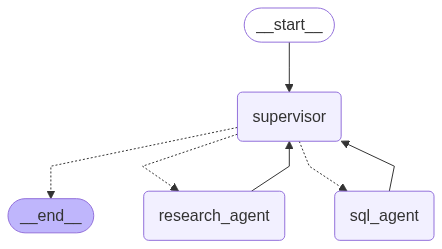

Arquitetura de Agentes

Para isso, criamos um sistema com três agentes:

1. Agente SQL

Responsável por acessar um banco de dados construído a partir da tabela 6318 do IBGE. Esse agente pode responder perguntas como:

“Qual é a taxa de desocupação atual no Brasil?”

Utilizamos a biblioteca sidrapy para extrair e tratar os dados, que são armazenados em um banco SQLite e acessados pelo agente via SQL.

2. Agente de Notícias

Esse agente usa ferramentas como o DuckDuckGo para buscar informações recentes na internet sobre o mercado de trabalho, como:

“O que dizem as notícias mais recentes sobre o desemprego no país?”

Ele é restrito a tarefas de pesquisa e retorna apenas o conteúdo relevante.

3. Agente Supervisor

É o cérebro da operação. Ele recebe a pergunta do usuário e decide qual agente deve ser acionado com base no contexto. Sua função é garantir que a resposta final seja completa, combinando dados estruturados e insights atualizados.

Abaixo, a imagem do Grafo resultante:

Como Funciona na Prática

Ao receber uma pergunta como:

“Qual é a taxa de desocupação atual e o que dizem as notícias sobre o mercado de trabalho?”

O Supervisor divide a tarefa:

- O Agente SQL consulta os dados oficiais do IBGE;

- O Agente de Notícias busca atualizações em tempo real;

- O Supervisor unifica os resultados em uma resposta única e coerente.

Conclusão

Este sistema é uma aplicação poderosa de IA aplicada à economia brasileira, unindo dados oficiais e conteúdo dinâmico. Com o uso de agentes coordenados pelo LangGraph, conseguimos criar um fluxo de trabalho que automatiza análises e fornece insights confiáveis e atualizados.

Se você é economista, cientista de dados ou apenas curioso sobre IA aplicada à economia, vale a pena explorar essa abordagem.

Quer aprender mais?

Conheça nossa Formação do Zero à Análise de Dados Econômicos e Financeiros usando Python e Inteligência Artificial. Aprenda do ZERO a coletar, tratar, construir modelos e apresentar dados econômicos e financeiros com o uso de Python e IA.

Referências

- LangGraph – Framework de agentes baseados em grafos

https://langchain-ai.github.io/langgraph/ - Tabela 6318 do SIDRA/IBGE – Condição na força de trabalho

https://sidra.ibge.gov.br/tabela/6318 - DuckDuckGO– Busca de informações em tempo real

https://duckduckgo.com/