Hoje, o IBGE divulga o IPCA-15, Índice de Preços ao Consumidor Amplo 15, que busca medir a inflação em geral do dia 16 do mês anterior ao 15 do mês de referência, seguindo de resto a mesma metodologia do IPCA. Aproveito a divulgação do índice para mostrar algumas coisas interessantes que vemos no curso de Introdução à Estatística usando o R em relação à construção de estatísticas descritivas e análise exploratória de dados de uma determinada variável.

Para começar, pegamos os dados através do pacote sidrar:

library(sidrar) ipca15 = get_sidra(api='/t/3065/n1/all/v/355/p/all/d/v355%202')

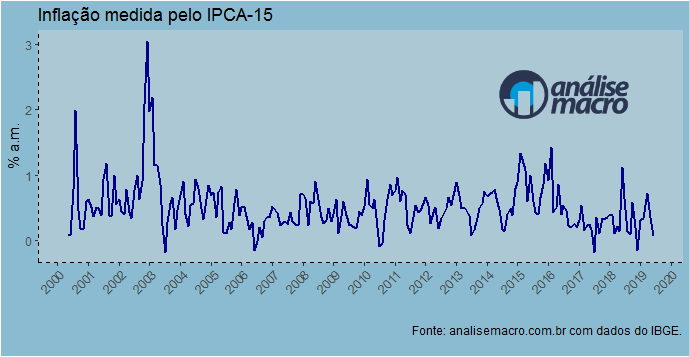

E abaixo visualizamos a nossa série.

Esse tipo de gráfico, a propósito, é feito com de forma customizada com o pacote ggplot2, que eu ensino no nosso Curso de Análise de Conjuntura usando o R. Uma vez que visualizamos a série, podemos notar uma característica importante dela: a existência de sazonalidade. Podemos explorar essa característica com o gráfico abaixo.

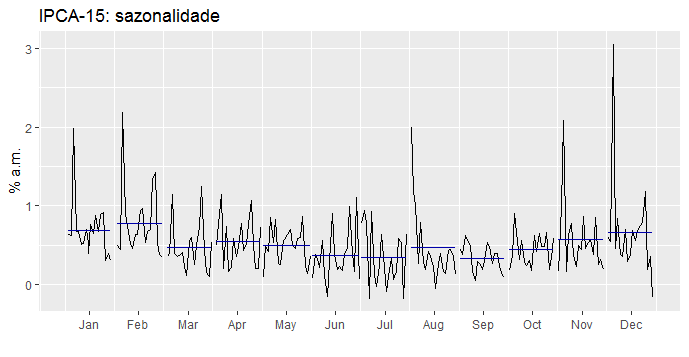

O IPCA-15, assim como o IPCA, apresenta uma sazonalidade bastante pronunciada. A inflação medida pelo índice cai ao longo do primeiro semestre e aumenta ao longo do segundo, de acordo, a propósito, com a produção ao longo do ano.

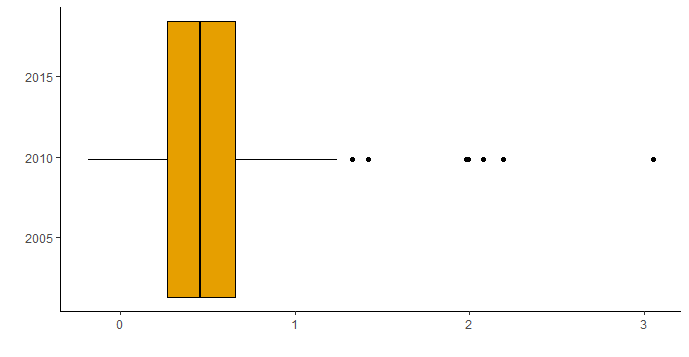

Uma vez identificada essa característica, podemos nos concentrar nas estatísticas descritivas da série. Uma forma simples de visualizar as principais métricas, podemos construir um boxplot da série.

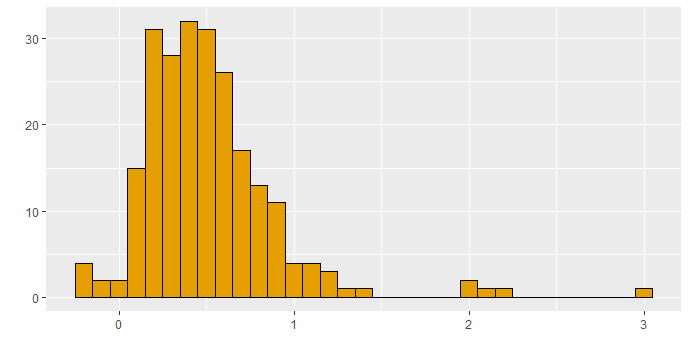

Observe que a mediana do IPCA-15 é de 0,46 e a média é de 0,51. Isso diz alguma coisa sobre a forma de distribuição da série, que podemos visualizar através de um histograma.

Isto é, temos uma assimetria à direita. O valor mínimo da série é, a propósito, de -0,18 e o máximo de 3.05, para um IQR de 0,39. Em outros termos, o primeiro quartil termina em 0,27 e o terceiro quartil em 0,66.

Em assim sendo, o intervalo mais provável de observações do IPCA-15 se situa entre 0,27 e 0,66, centrado em 0,46.

Esse tipo de análise descritiva dos dados serve, por fim, de preâmbulo para qualquer esforço de modelagem e previsão que poderíamos fazer em relação à nossa série.

_________________________________

Update: O script do exercício está disponível aqui. Um vídeo sobre como feito o post pode ser visto no Canal da AM no Youtube.