Agentes de IA podem automatizar a coleta, tratamento e análise de informações, entregando insights prontos para a tomada de decisão. Combinando modelos de linguagem avançados com ferramentas de acesso a dados, é possível construir soluções que buscam informações em tempo real e as processam de forma autônoma.

Etapas para criar o agente

1. Definir as fontes de dados

No Brasil, existem diversas APIs públicas que fornecem dados macroeconômicos. Algumas das mais relevantes são:

- Banco Central do Brasil (BCB)

- SGS (Sistema Gerenciador de Séries) – fornece séries históricas como inflação, câmbio, PIB, etc.

- Sistema de Expectativas de Mercado (Focus) – disponibiliza as expectativas do mercado para inflação, juros e crescimento econômico.

- Instituto Brasileiro de Geografia e Estatística (IBGE)

- SIDRA – permite consultar dados estatísticos sobre população, produção, preços e outros indicadores.

- IPEADATA

- Reúne diversas séries econômicas, sociais e demográficas.

2. Criar ferramentas de coleta

Cada fonte deve ter uma ferramenta dedicada para buscar os dados na API correta e retorná-los em um formato estruturado (JSON ou DataFrame).

Exemplos de bibliotecas úteis:

bcb– para acessar séries e expectativas do Banco Central.sidrapy– para acessar tabelas do SIDRA/IBGE.requestsoupandas– para integrar outras APIs.

3. Criar ferramentas de análise

Além de coletar, o agente precisa processar os dados. Exemplos de funções úteis:

- Calcular médias ou variações entre datas.

- Resumir estatísticas (mínimo, máximo, desvio padrão).

- Obter o primeiro ou último valor de uma série temporal.

Essas funções recebem os dados em JSON e retornam resultados prontos para serem usados na resposta final.

4. Integrar com um modelo de linguagem

Um LLM com suporte a ferramentas, como o Gemini ou GPT, é responsável por:

- Interpretar a pergunta do usuário.

- Decidir quais ferramentas chamar.

- Gerar a resposta final baseada nos resultados das ferramentas.

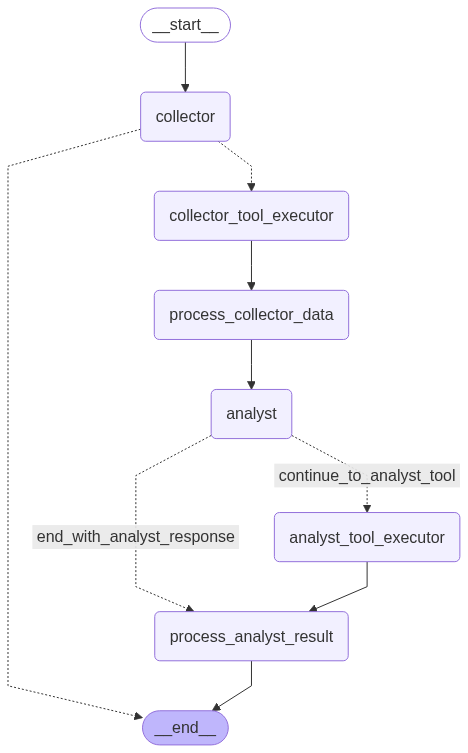

5. Organizar o fluxo de trabalho

O fluxo básico de um agente de análise de dados é:

- Receber a pergunta do usuário.

- Coletar os dados adequados por meio das ferramentas.

- Executar funções de análise sobre os dados coletados.

- Responder ao usuário de forma direta e contextualizada.

Benefícios

- Automação da coleta e análise de indicadores.

- Escalabilidade, permitindo atender múltiplas demandas simultaneamente.

- Integração com diferentes fontes de dados oficiais em tempo real.

- Flexibilidade, podendo adicionar novas ferramentas e APIs conforme a necessidade.

Com essa abordagem, é possível transformar relatórios manuais em análises dinâmicas, fornecendo respostas rápidas e confiáveis para questões econômicas e estatísticas.

Quer aprender mais?

Conheça nossa Formação do Zero à Análise de Dados Econômicos e Financeiros usando Python e Inteligência Artificial. Aprenda do ZERO a coletar, tratar, construir modelos e apresentar dados econômicos e financeiros com o uso de Python e IA.